GPUサーバーとは、GPU(Graphics Processing Unit)を搭載し、AIの機械学習や推論処理に必要な大規模並列計算を高速に実行できるサーバーです。

AIサーバーは、このGPUサーバーとほぼ同義ですが、よりAI処理に特化して最適化したサーバーを指します。

現代のビジネス環境では、従来のCPUベースのサーバーではAI特有の膨大な計算処理に対応困難なため、これらの専用サーバーの導入が急速に進んでいます。

本記事では、GPUサーバー・AIサーバーの仕組みから導入形態、選定ポイントまで、企業のAI活用に必要な情報を徹底解説します。

GPUサーバー・AIサーバーとは?

まず、GPUサーバーの概要とAIサーバーとの違いについて解説します。

GPUサーバーの仕組みと役割

GPUとは主に画像・映像を処理し描画するための計算処理を行うハードウェアです。

GPUサーバーとは、文字通りこのGPU(Graphics Processing Unit)が搭載されたサーバーです。

通常のサーバーはCPUを主な処理エンジンとして汎用的な計算処理に使われるのに対して、GPUサーバーは、主にグラフィック処理など、優れた並列計算能力を活かした処理を行うシステム用のハードウェアとして採用されます。

GPUとCPUの違いは、その設計思想にあります。

CPUは少数で高性能のコアを備え、さまざまな種類のタスクを逐次的にこなせる汎用性の高さが特長です。

一方、GPUは数千規模のコアを並行に稼働させることで、同じような演算を大量に同時実行することに特化しています。

GPUサーバーは、グラフィック処理を必要とする業界以外あまり採用されてきませんでしたが、このアーキテクチャが機械学習やディープラーニングのような、膨大な計算を要する処理を高速に実行するのに適しているとされ、AIの普及に伴い爆発的に採用が広がっています。

AI処理に最適化されたAIサーバー

AIサーバーとは、AIの処理に特化して最適化されたサーバーシステムを指します。

AIサーバーは、ディープラーニングをはじめとする機械学習ワークロードに最適化されたコンポーネントで構成されています。

これまでの汎用的なサーバーとは異なり、GPUなどによる大規模並列計算、高速なデータアクセス、学習済みモデルの効率的な推論処理に適しています。

AIサーバーは、AIの用途として使うことを想定した呼び方であり、技術的な観点ではGPUサーバーとほぼ同義と考えてよいでしょう。

AI用途以前にも、GPUをグラフィック処理だけでなく汎用計算に活用するというアプローチは存在しており、「GPGPU」と呼ばれています。

GPUサーバーのAI・機械学習処理への応用は、まさにこのGPGPUの例の1つとも言えます。

GPUサーバー・AIサーバーの用途と求められている背景

なぜ今、GPUサーバーやAIサーバーが注目されているのか、その用途や背景について解説します。

AI開発の迅速化に不可欠

現代の企業が直面している課題はさまざまありますが、特に労働力不足と生産性低下が深刻化しています。

人口減少に伴う労働力の制約は、多くの産業で業務効率化・自動化できるAI技術への期待を高める要因になっています。

AIを用いたシステム導入を進めている企業では、AIモデルを構築するために、大量のデータセットを用いて機械学習を行う必要があります。

しかし、これをもしCPUベースのサーバーで行うとすれば膨大な時間がかかり、開発のボトルネックとなってしまいます。

また、一度AIモデルが完成したとしても、それで終わりではありません。

でき上がったAIモデルの性能を検証しつつ、パラメーターをチューニングしながら再度膨大な訓練データで繰り返し最適化する必要があります。

仮にCPUでこの処理を行った場合、数週間から数ヶ月の期間を要しますが、一方GPUの並列処理能力を活用すれば、同じ処理を数時間から数日に短縮することが可能です。

GPUサーバー・AIサーバーは、機械学習処理だけでなく、でき上がったAIモデルによる推論処理においても必要です。

特にユーザーからの入力に対してリアルタイムな応答が求められるアプリケーションは処理スピードの良し悪しがクリティカルな問題です。

画像認識、自然言語処理、音声認識といった分野では、ユーザーエクスペリエンスの品質に直結します。

こうした要件を満たすため、GPUサーバー・AIサーバーの導入が求められています。

生成AIの追加学習にも必要

ChatGPTやGeminiなど大規模言語モデル(LLM)の登場は、AI技術の可能性を一般のビジネスユーザーにも身近なものとして認識させ、多くの企業が自社業務へのAI活用を本格的に検討するきっかけとなりました。

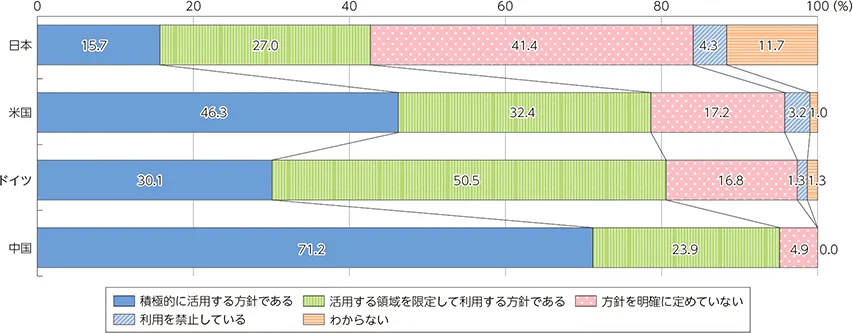

総務省の「情報通信白書 令和6年版」によると、国内企業の約4割が生成AIを業務で活用する方針を固めています。

それでも米国(約8割)や中国(9割以上)に比べると少ない割合です。

生成AIを企業で活用する方法としては、各種サービスをそのまま使う以外に、自社データを活用してモデルをファインチューニングするという方法もあります。

汎用的な生成AIモデルでは対応できない業界の専門知識や、自社の業務に特化した知識に対応するため、独自の学習データを用いてモデルの追加学習を行うということです。

このとき、このファインチューニングにも、一定規模の計算リソースと継続的な学習処理が必要であり、結果としてGPUサーバー・AIサーバーの需要が増加しています。

また、この生成AIの分野においても同様に、推論処理に計算リソースが必要です。ユーザーからの入力に素早く応答するという実用レベルのAIシステムを実現するためには、やはり高性能なGPU環境が欠かせません。

GPUサーバー・AIサーバーの導入方法

GPUサーバー・AIサーバーの選択において重要な視点は下記の3つです。

- サイジング

- 設置環境との適合性

- 導入方式

それぞれ詳しく解説していきます。

サイジング

GPUサーバーのコストパフォーマンスを最大化し、過剰な投資を避けるためには、サーバーを構成するハードウェアやスペックがそれぞれ適切かを確認することが大切です。

完成品のGPUサーバーを購入する場合、用途に対して部分的にスペック過剰になってしまうかもしれません。

用途に応じて最適なGPUを選ぶことで、コストパフォーマンスを最大化できます。

AI開発においては、学習処理と推論処理で求められる性能が異なるため、それぞれの用途に適したGPU選びが重要です。

現在のエンタープライズ向けGPU市場では、NVIDIAが世界シェアNo.1を誇りデファクトスタンダードとなっています。

2023年に登場した同社のデータセンター向けGPU製品の最新版「H200」はLLMや生成AIの学習・推論に最適です。

前モデルの「A100」も2020年に登場して以降、HPCや科学計算で多くの実績を持ちます。

設置環境との適合性

どれだけ用途に適していても、GPUサーバーを設置できる環境が整っていなければ運用できません。

特にGPUサーバーは大きな電力を必要とするため、設置面積、供給電力、冷却装置、ネットワークなどが十分かを事前に確認しておく必要があります。

一般的にはデータセンターに設置されることが多いですが、すべてのデータセンターがGPUサーバー設置に対応できるわけではありません。

導入方式

GPUサーバー・AIサーバーの導入形態は、以下のようにいくつかの選択肢があります。

- 購入

物理サーバーを自社で購入し、オンプレミス環境に設置します。サーバーベンダーが提供する完成品を購入する方法と、個別コンポーネントを組み合わせたカスタム構成を選ぶ方法があります。長期的な利用が前提で、データセキュリティや処理性能のコントロールを自社で完全に行う必要がある企業に適しています。 - レンタル

初期投資を抑えつつ、短期間での利用やスケーラビリティを重視する場合に有効です。GPUは購入費が高額であるため、減価償却の期間を費用とします。この間にGPUが進歩してしまい購入後に陳腐化してしまうというリスクを回避できるメリットもあります。増設や撤去が購入に比べて容易で、トラブル時のサポートも充実しています。 - クラウド

クラウドベンダーのデータセンターに設置されたGPUサーバーリソースをインターネット経由で利用します。自社で物理的なサーバーのメンテナンスをする必要がなく、必要な時に必要な分だけリソースを利用できる柔軟性が魅力です。ただし、従量課金制であるため、長期間の利用の場合は、コストが高騰する傾向があります。

導入方式を選ぶ際は、利用期間で考えることがポイントです。

短期的な検証には購入は適さず、長期的なサービスの基盤にはクラウドは割高になるかもしれません。

また、「平時はほとんど使用しないが、月に一度大量処理が発生する」といった用途には、柔軟性の高いクラウドが適している場合もあります。

データセキュリティ要件や社内の運用体制も踏まえて検討する必要があります。

GPUサーバー・AIサーバー導入の注意点やポイント

GPUサーバー・AIサーバーと従来のサーバーの大きな違いの1つとして、消費電力が挙げられます。

先述した用途に応じたサーバーのスペックに加えて、電力や冷却要件なども注意しなければなりません。

電力供給能力

高密度に集約したGPUサーバー・AIサーバーの消費電力は通常のサーバーの数倍から十倍以上に達することがあり、仕様を把握した上で電源を確保する必要があります。

1ラックに供給できる電源容量はデータセンターによって異なるため、サーバーの要求する電源容量を満たすデータセンター選定が不可欠となります。

単一ラックで20kVA以上の電力供給が必要になることも珍しくなく、既存の設備では対応できないケースが頻発します。

導入前には消費電力の算出と、設置場所で供給できる電力を確認しておく必要があります。

空調・冷却システム

GPUサーバー・AIサーバーを運用する上で、空調は電気と同じくらい大切な要素です。

GPUサーバーの排熱とその風量は通常のサーバーよりも大きいため、空気の流れを考慮した配置が求められます。

設置場所を誤れば、高温の排気がラック内で再循環したり、他のラックが吸い込んでしまったりして、冷却できなくなる可能性があります。

高温に弱い電子部品の寿命が極端に短くなり、サーバー故障につながるかもしれません。

サーバー以外の機器や運用体制

AI用途にシステムを構築する際は、ストレージやネットワーク、ソフトウェア環境も含めたうえで処理能力を最大限に発揮できる環境を整えることが大切です。AI開発では大量のデータを扱うため、適したシステム構成を検討する必要があります。

システムの信頼性は、スペックだけでなく、それを安定的に運用できる人材がいてはじめて成り立ちます。GPUサーバーの安定した運用には、専門人材を含む運用体制の構築が欠かせません。

GPUサーバー製品とAI向けソリューション

ここまで紹介したGPUサーバー、AIサーバーは多くのサーバーベンダーから提供されています。

TD SYNNEXが取り扱うHewlett Packard Enterprise(HPE)でも、サーバー製品「ProLiant」シリーズでNVIDIAのGPUを搭載可能なモデルを多数取り揃えています。

HPE ProLiant Compute DL380a Gen12

多数のサーバーラインアップの中でも、AI開発向けに適しているのが、HPE ProLiant Compute DL380a Gen12です。

同製品は、最大144コアのIntel® Xeon® 6プロセッサーと、最大8基の高性能ダブルワイドGPUを搭載可能。

これにより、AI学習や推論ワークロードのパフォーマンスを飛躍的に向上させます。

また、最新のPCIe Gen5スロットと高速なDDR5メモリが、データ転送と処理速度を大幅に高め、ボトルネックを解消します。

冷却システムでは、空冷および直接液冷(DLC)を含む冷却方式をサポートし、消費電力あたりの性能を改善することで、データセンターの集約率を高め、電力コスト削減にも寄与します。

セキュリティ面では、独自の組み込みASICテクノロジーである「HPE Integrated Lights-Out (iLO)7」にて新しい防御層を備え、FIPS 140-3認証への対応や、NISTやCNSA 2.0に準拠したポスト量子暗号 (PQC) に対応しています。

HPE Private Cloud AIによる統合ソリューション

HPEでは、サーバー製品単体を提供するだけでなく、AI開発に必要なソフトウェア、ハードウェア、運用基盤を統合した、事前検証済みのプライベートクラウドソリューションとして「HPE Private Cloud AI」を提供しています。

NVIDIAのGPUやAIソフトウェア、HPEのインフラなどの技術をワンストップで提供することで、ユーザー企業は各技術を自社で個別に組み合わせて検証したりする必要なく、AI開発に専念できる環境を構築できます。

同ソリューションは、自社独自の生成AI環境を迅速に構築できるほか、高いパフォーマンスで優れた推論能力を提供するインフラとして活用できます。

3クリックでの簡単デプロイや直感的な管理画面により、導入と運用を効率化し、AI開発者それぞれの役割に合わせた機能を提供します。

まとめ

GPUサーバー・AIサーバーは、企業のAI開発を加速する重要なインフラです。

通常のサーバーでは難しい、機械学習の時間の短縮やリアルタイム推論処理を可能にする環境を構築できます。

もっとも、物理的な機器を自社で管理する場合には、消費電力や冷却設備といった課題への対応策を検討する必要があるほか、データセンター向けGPUは非常に高額な製品であるため、利用用途や期間、目的に合わせて導入方式の慎重な検討が必要です。

ハードウェアはもちろん、その上位レイヤーのさまざまな技術スタックも含めて、適切な運用体制の構築も重要です。

TD SYNNEXでは、先ほど紹介したHPEを含め、企業のAI活用を支援するさまざまなハードウェア、ソフトウェア製品を提供可能です。

自社のAI戦略に適した製品をご検討の際は、ぜひご相談ください。

「実践的AI活用」の最前線がわかる資料を公開中!

neoAI の業務アシスタント活用、HPEのオンプレミスAI インフラ、TD SYNNEX のクラウド提案、エクイニクスの液体冷却データセンターなど、AIを実践に活かすためのソリューションを紹介しています。